AI成”能源黑洞” NVIDIA AI伺服器功耗8年激增100倍

隨著AI產業的快速發展,運算能力的需求亦在急遽上升,無論是透過硬體技術,亦或大規模AI集群建設,企業皆在努力提升其AI處理能力,然而此亦帶來了巨大的能源消耗問題。

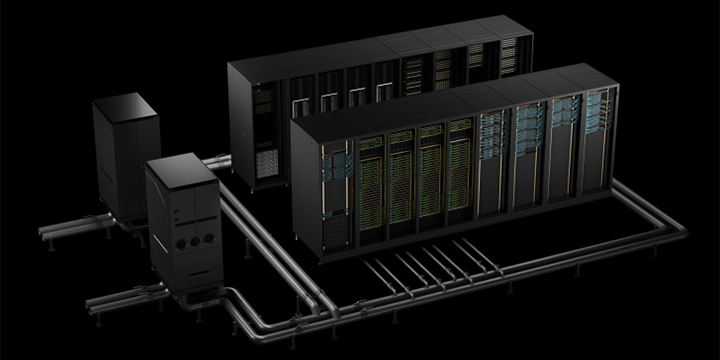

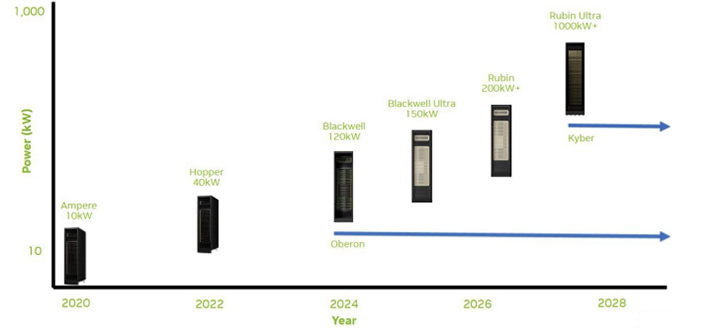

根據分析師分享之數據,NVIDIA AI伺服器平台於每一代更新中皆經歷了顯著的功耗增長,從Ampere到Kyber架構,功耗八年間提升了100倍。此巨大的功耗增長主要歸因於每一代每機架GPU數量的增加,以及每個GPU TDP的提升。

例如:使用Hopper架構時,以每機架10KW的額定功率運作,而採用Blackwell架構時,由於GPU數量的增加,此功率幾乎提升至120KW。

除了GPU數量的增加,其它因素如先進的NVLink/NVSwitch網路架構、新一代機架設計以及持續的機架利用率,亦導致了超大規模資料中心的能耗以驚人的速度成長。

如今,大型科技公司紛紛參與”誰擁有更大規模AI機架”的競賽,衡量標準已經從傳統的運算能力轉變為”吉瓦(GW)”,如OpenAI、Meta等公司計劃於未來幾年內增加超過10吉瓦的運算能力。

作為對照,AI超大規模企業消耗的1吉瓦能源,足以供應約100萬美國家庭,隨著大型科技公司紛紛建設大規模資料中心,單一資料中心的能耗已經相當於一個開發中國家或幾個美國大州的用電量。

另外,國際能源總署(IEA)2025年的「能源與AI」研究報告預測,至2030年,AI的能源消耗將倍增,幾乎是電網成長速度的四倍。