人工智慧大戰Intel怎會缺席?首發神經網路處理器Nervana

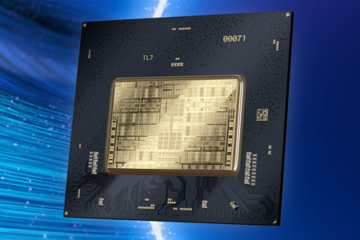

Intel今天在WSJDLive全球技術大會上發佈了自家第一款自家專為深度學習而打造的神經網路處理器Nervana(NNP),最快今年底交貨。Intel稱利用Nervana處理器可以幫助不同行業發揮最大的性能,找到自身最大價值。

Intel的新聞稿中其實並沒有多少關於Nervana處理器的實質性內容,通篇都是在講述Intel已經在不同領域展開研究,先有了17 qubit的Qutech量子處理器,現在又有了Nervana人工智慧處理器,它們都在不同領域發光發熱。並且會繼續對前沿領域進行創新性的研究、投資新硬體、演算法,必要時會收購相關初創公司,保持技術領先優勢。

而超能網另外找到一篇介紹Nervana處理器的部落格,是由Nervana處理器主導研發者Naveen Rao所撰寫的,裡面提到了一些關於該神經網路處理器的關鍵技術,還是相當有趣的。

現在機器學習、深度學習已經成為全球廣泛使用的資料分析、研究方式,不過目前已有的處理器在運行相關程式總是顯得力不從心,因為X86處理器其通用性架構本來就不擅長於大資料處理,因此像NVIDIA開發的計算卡就派上用場了。而Intel為了彌補這方面缺陷,開始了Nervana處理器的開發,其特點如下:

新的記憶體體系

矩陣乘法以及矩陣轉置一直都是深度學習中的核心運算操作,這些計算不同於平常運算,很大程度上它們都是已知的操作,因此Intel Nervana處理器摒棄了原來的標準的緩存結構,而是利用軟體達到記憶體管理,這樣壓榨出處理器的最大性能(估計意思就是不需要原來複雜的緩存結構和控制單元電路,全部讓位給計算單元,達到更高的計算性能)。

新一代的AI模型

設計有高速片外互聯通道,可以讓Nervana處理器達到高速的雙向資料傳輸,多個處理器甚至可以組成一個更加龐大的神經網路系統,可以達到更大的計算量,説明客戶快速獲取有用資料。

專為人工智慧設計的Flexpoint運算

神經網路計算在單個晶片上很容易受到功耗以及記憶體頻寬限制,為了達到更高的輸送量,Intel發明了一種新的運算Flexpoint,可以達到標量的點乘和加法,而且這種計算單元可以節省下不少的電路電晶體,因此可以提升處理器的密度,並且減少功耗。

Intel表示,Nervana處理器並非只有一款,多代處理器正在打造當中,在未來這些產品有助於在2020年達到深度計算數百倍的性能提升。而第一個合作方就是Facebook,雙方將會深入合作應用,但未具體公佈相關細節。