Supermicro 推出支援 NVIDIA Blackwell 的機櫃級隨插即用液冷 AI SuperCluster

Supermicro 推出專為雲端原生解決方案設計的可立即部署式液冷型 AI 資料中心,透過 SuperCluster 加速各種生成式 AI,並針對 NVIDIA AI Enterprise 平台最佳化。

AI 受到各行各業及大眾的注意,應用也更為多元,為了提升 AI 運算,從 AMD、Intel、NVIDIA 等都分別推出更新且更高性能的 AI 運算相關產品。而要發揮這些運算能力,當然就要做成伺服器並放置於運算中心。

以伺服相關產品知名的 Supermicro 宣布推出專為雲端原生解決方案而設計可立即部署式液冷型 AI 資料中心,透過 SuperCluster 加速各種生成式AI 運用,更特別針對 NVIDIA AI Enterprise 軟體平台最佳化,適用於生成式 AI 開發與部署。利用 Supermicro 的 4U 液冷技術,可充分發揮 NVIDIA 推出的 Blackwell 強大的 20 PetaFLOPS AI 性能,與較早的產品相比,可提供 4倍 AI 訓練以及30倍推論效能,還可節省額外成本。配合率先上市的策略,Supermicro 近期推出完整的 NVIDIA Blackwell 架構系列產品,可支援新型 NVIDIA HGX B100、B200 和 GB200 Grace Blackwell Superchip。

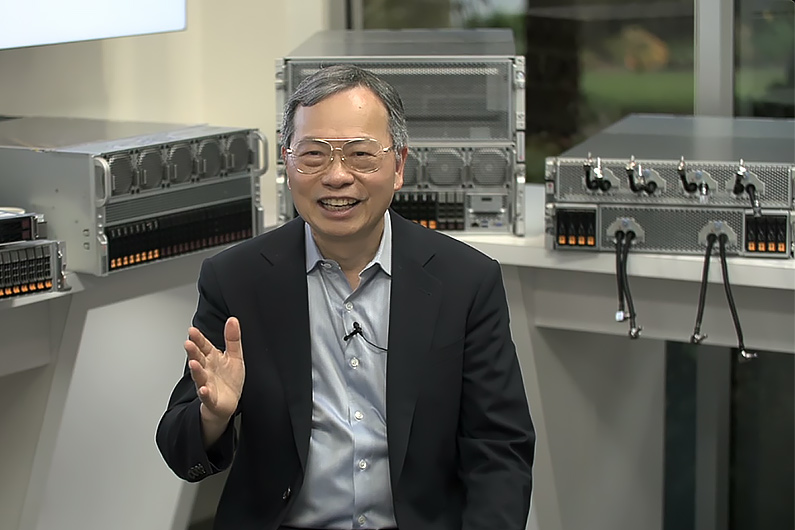

Supermicro 總裁暨執行長梁見後表示:「Supermicro 打造與部署具有機櫃級液冷技術的 AI 解決方案方面持續領先,資料中心的液冷配置設計可幾近免費,並透過能持續降低用電量的優勢為客戶提供額外價值。我們的解決方案針對 NVIDIA AI Enterprise 軟體最佳化,滿足各行各業的客戶需求,並提供世界級效率的全球製造產能,因此得以縮短交付時間,更快提供搭配 NVIDIA HGX H100、H200以及即將推出的 B100、B200 和 GB200 可立即使用型液冷或氣冷運算叢集。從液冷板到 CDU 至冷卻塔,我們的機櫃級全方位液冷解決方案最大可以降低資料中心 40% 持續用電量。」

Supermicro 在台北國際電腦展中展示即將推出,並針對 NVIDIA Blackwell GPU 最佳化的系統,包括基於 NVIDIA HGX B200 的 10U 氣冷系統和 4U 液冷系統。Supermicro 也將提供 8U 氣冷型 NVIDIA HGX B100 系統、NVIDIA GB200 NVL72 機櫃(具有72個以 NVIDIA NVLink 交換器連接的 GPU)與新型 NVIDIA MGX 系統(支援 NVIDIA H200 NVL PCIe GPU與最新發表的 NVIDIA GB200 NVL2 架構)。

NVIDIA 創辦人暨執行長黃仁勳表示:「生成式 AI 正在推動整個運算堆疊的重置,新的資料中心將會透過 GPU 進行運算加速,並針對 AI 最佳化。Supermicro 設計頂尖的 NVIDIA 加速運算和網路解決方案,使價值數兆美元的全球資料中心能夠針對 AI 時代最佳化。」

隨著大型語言模型(Large Language Model,LLM)的快速發展以及 Meta Llama-3 和 Mistral Mixtral 8x22B 等模型不斷推出,企業更容易取得並使用最先進的 AI 模型。簡化 AI 基礎設施並以最具成本效益的方式提供存取能力,對於支援目前的快速AI變革至關重要。Supermicro 雲端原生 AI SuperCluster 使即時存取的雲端便利性和可攜性之間得以連結,並透過 NVIDIA AI Enterprise 讓任何規模的 AI 專案,從評估測試階段順暢地進行到實際作業階段,提供可在任何地方運作並安全管理資料的靈活性,包括自架系統或地端大型資料中心。

託管服務包括基礎架構的選擇、資料共享和生成式 AI 策略控管,NVIDIA NIM 微服務是 NVIDIA AI Enterprise 一部分,可在無缺陷情況下提供託管生成式 AI 和開放原始碼部署優勢。其多功能推論運作環境採用微服務,可加速部署從開源模型到 NVIDIA 基礎模型等各種生成式 AI。此外 NVIDIA NeMo 可實現透過資料管理、進階客製化和檢索增強生成(Retrieval-Augmented Generation,RAG)的客製模型開發,以實現企業級解決方案。與搭配 NVIDIA AI Enterprise 的 Supermicro SuperCluster 整合後,NVIDIA NIM 將為可擴展、加速型生成式 AI 部署提供最快途徑。

Supermicro 目前推出的生成式 AI SuperCluster 產品包

括:

具有 256個 H100/H200 GPU 的液冷式 Supermicro NVIDIA HGX H100/H200 SuperCluster,共五機櫃的可擴展運算單元,其中一櫃為網路專用。

具有 256個 HGX H100/H200 GPU 的氣冷型 Supermicro NVIDIA HGX H100/H200 SuperCluster,為九個機櫃的可擴展運算單元,其中一櫃為網路專用。

具有 256個 GH200 Grace Hopper Superchip 的 Supermicro NVIDIA MGX GH200 SuperCluster,為九機櫃規模的可擴展運算單元,其中一櫃為網路專用。

Supermicro 的 SuperCluster 支援 NVIDIA AI Enterprise,其中包括 NVIDIA NIM 微服務和 NVIDIA NeMo 平台,可實現客製化端對端生成式 AI,並針對 NVIDIA Quantum-2 InfiniBand 以及具有每 GPU 400Gb/s 網速的新型 NVIDIA Spectrum-X 乙太網路平台最佳化,可擴展到具有數萬個 GPU 的大型運算叢集。

此外,Supermicro 預計將推出液冷型 Supermicro NVIDIA HGX B200 SuperCluster、氣冷型 Supermicro NVIDIA HGX B100/B200 SuperCluster 以及液冷型 Supermicro NVIDIA GB200 NVL72 或 NVL36 SuperCluster。

Supermicro 的 SuperCluster 解決方案針對 LLM 訓練、深度學習以及大規模與大批量推論最佳化,Supermicro 的L11 和 L12 驗證測試及現場部署服務可為客戶提供無縫順暢體驗,客戶收到隨插即用的可擴充單元後即可輕鬆部署於資料中心且更快取得效益。