NVIDIA推出第二代DGX Station A100 AI伺服器,包含更新採用的80GB A100 Tensor Core GPU

NVIDIA剛剛宣布了基於Ampere A100 Tensor Core GPU的第二代DGX Station AI伺服器。DGX Station A100擁有兩種配置,並具有經過更新的A100 Tensor Core CPU,可提供雙倍的記憶體和AI等級的數位觸發器功能。

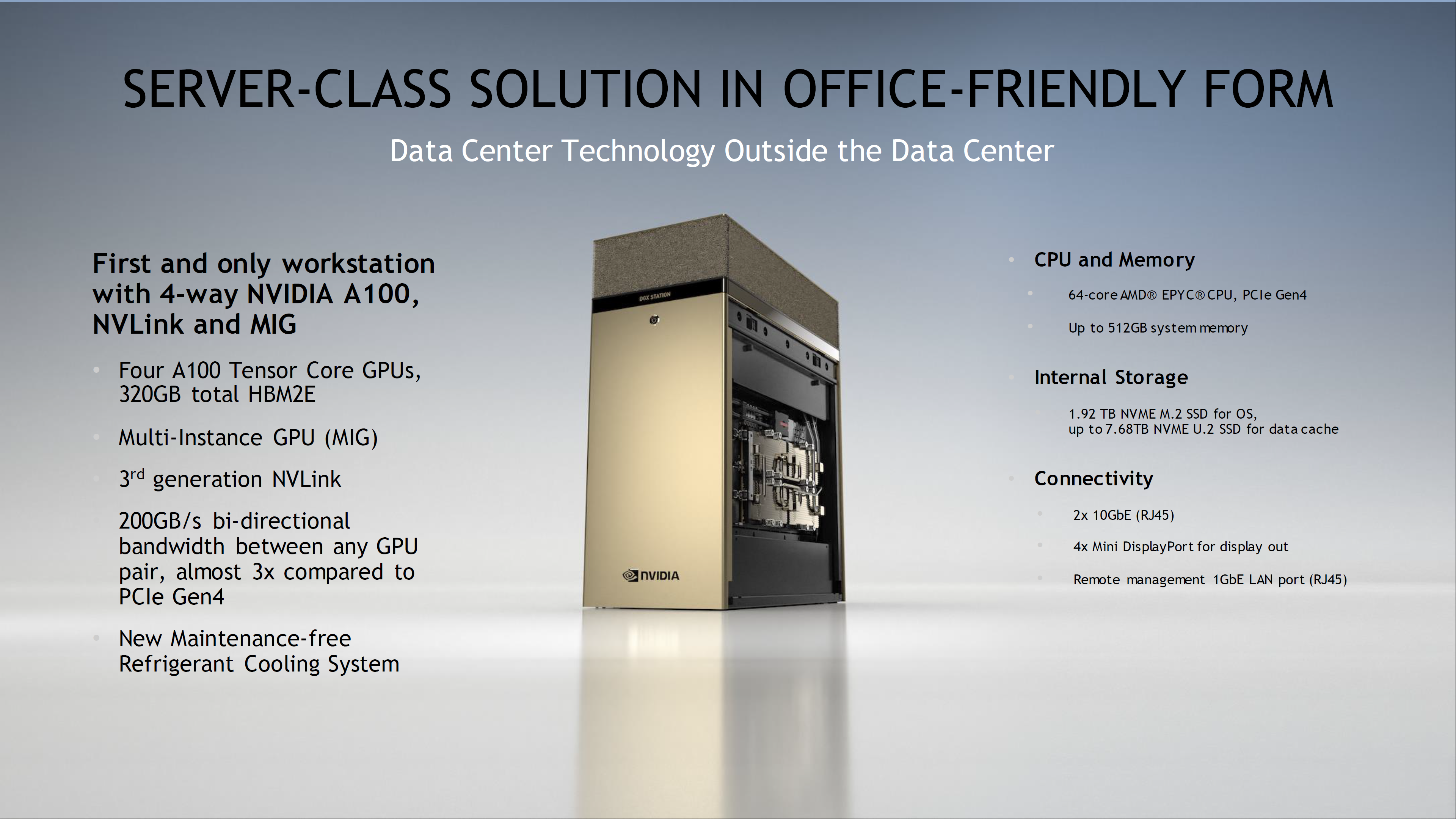

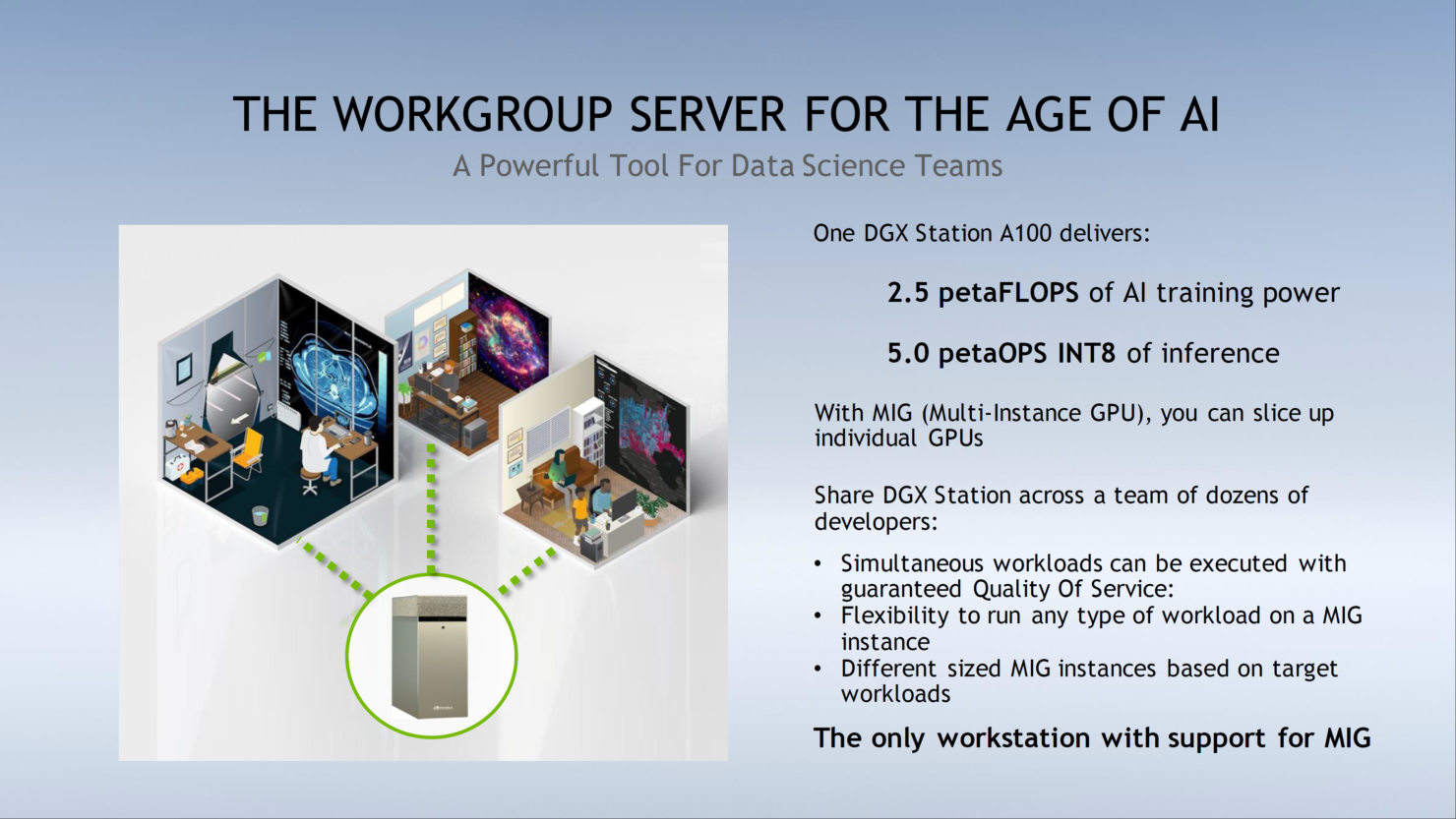

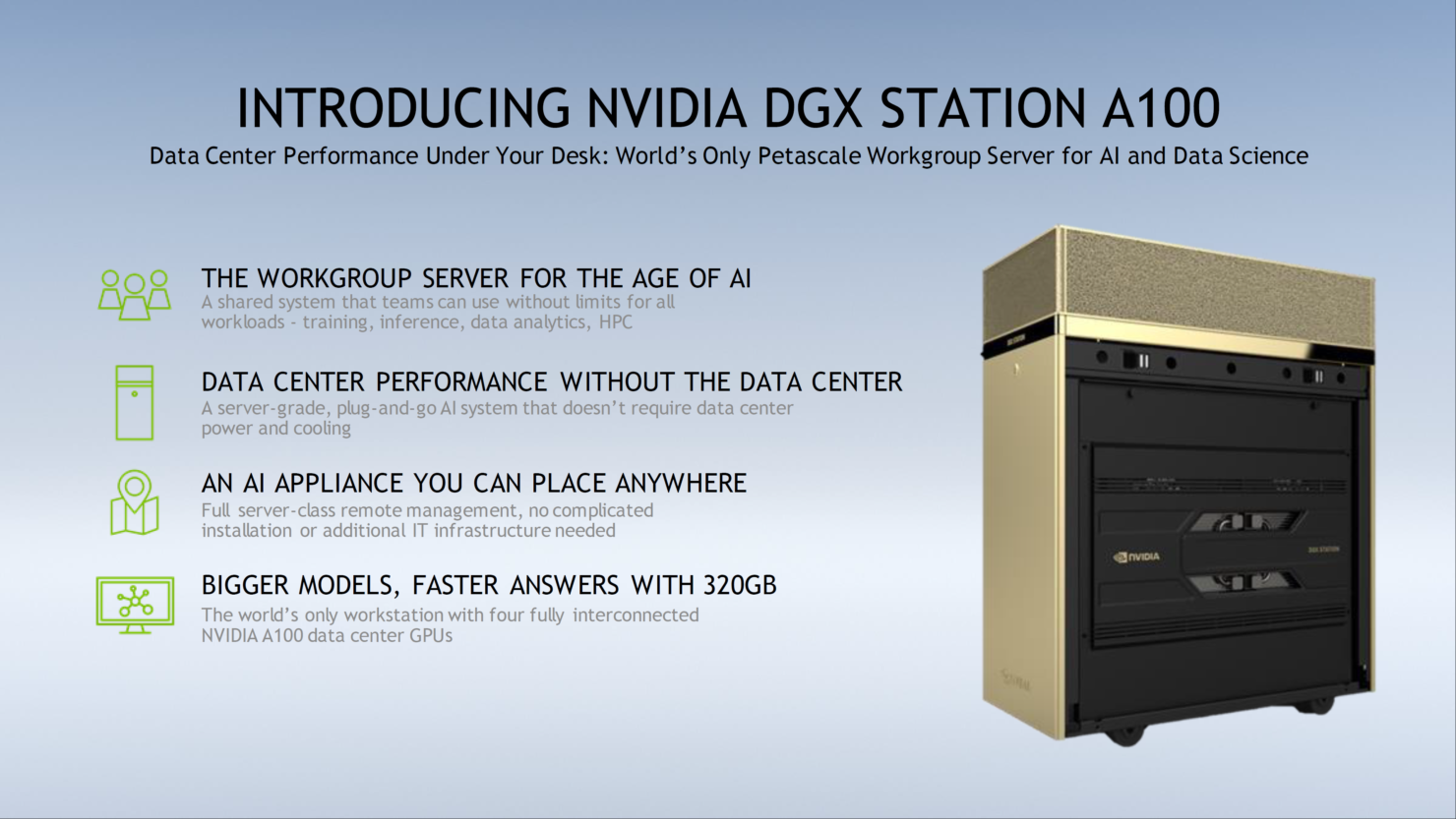

NVIDIA DGX Station A100主要針對AI市場,可為世界各地的公司辦公室,研究機構,實驗室或家庭辦公室提高機器學習和數據科學性能。根據NVIDIA的說法,DGX Station A100被設計為專用於AI研究中最快的伺服器。

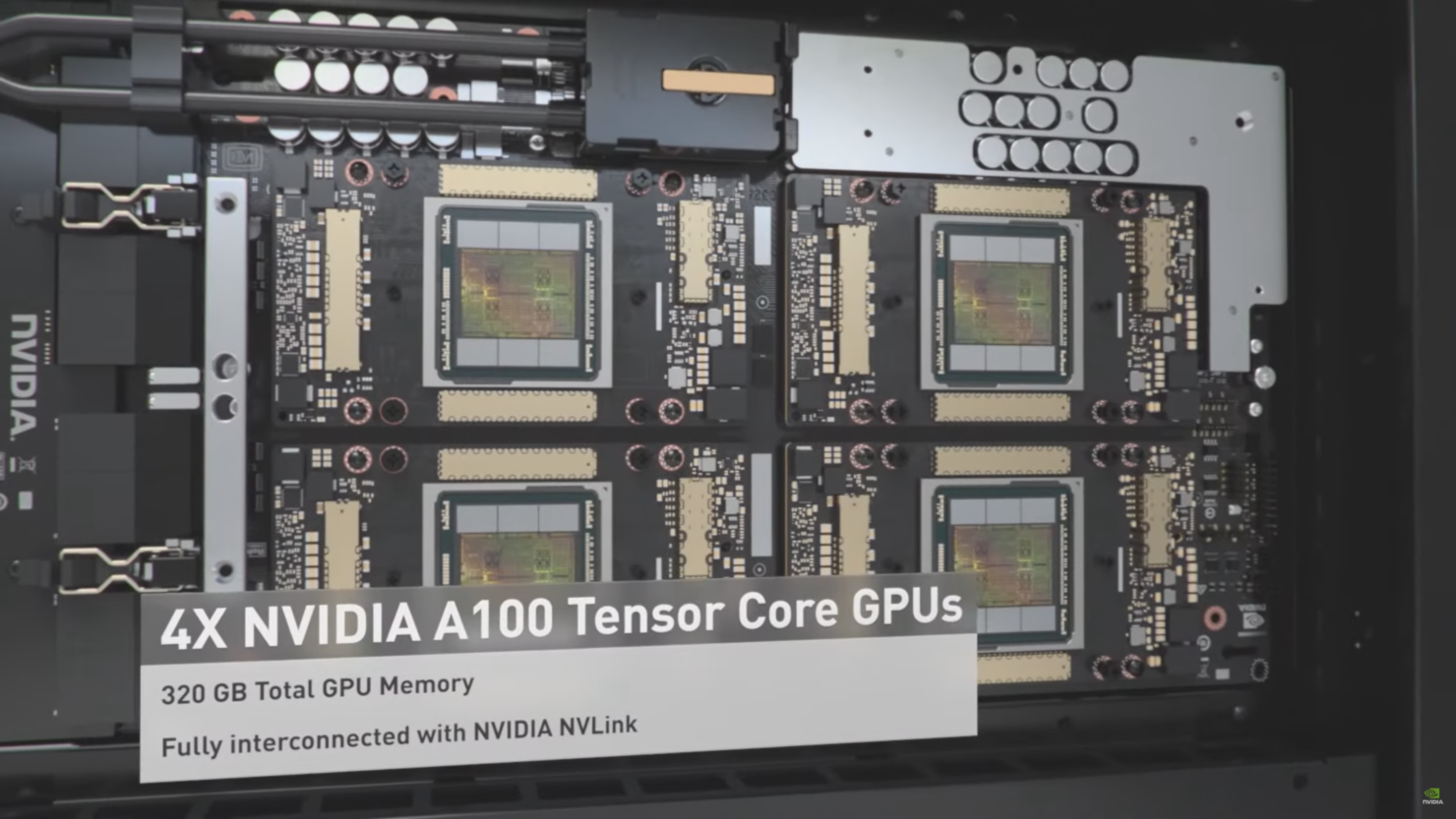

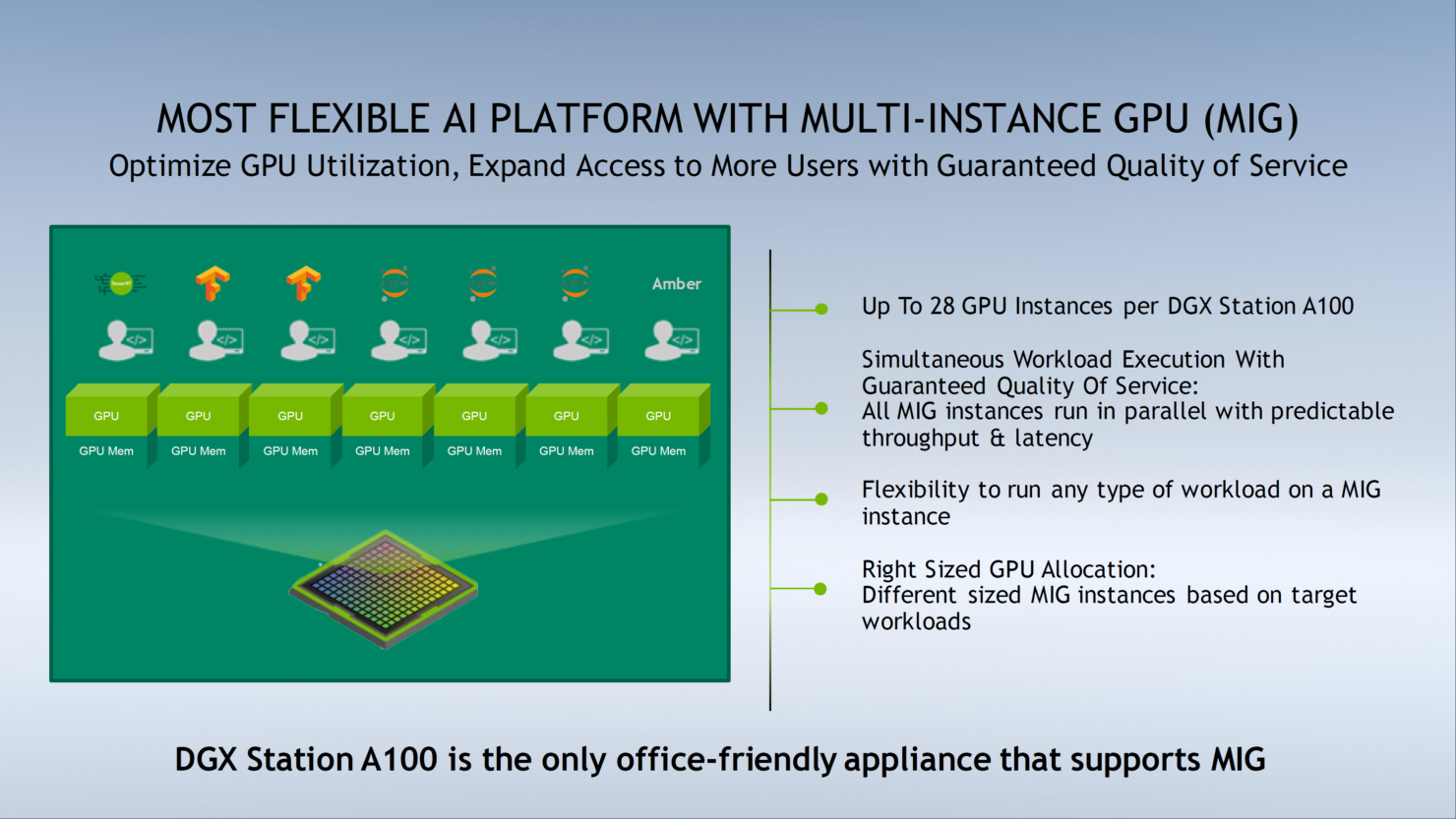

根據規格NVIDIA DGX Station A100總共由四個A100 Tensor Core GPU提供支援。這些不僅是A100 GPU,因為NVIDIA更新了原始規格,可容納兩倍的記憶體。DGX Station A100中的NVIDIA A100 Tensor Core GPU隨附80GB的HBM2e記憶體,是原始A100的兩倍。這意味著DGX Station總共擁有320GB的總可用容量,同時完全支援MIG(多實例GPU協議)和第三代NVLink支援,在任何GPU對之間提供200GB/s的雙向頻寬,並且互連速度提高了3倍速度比PCIe Gen 4還高。其餘的A100 Tensor Core GPU規格保持不變。

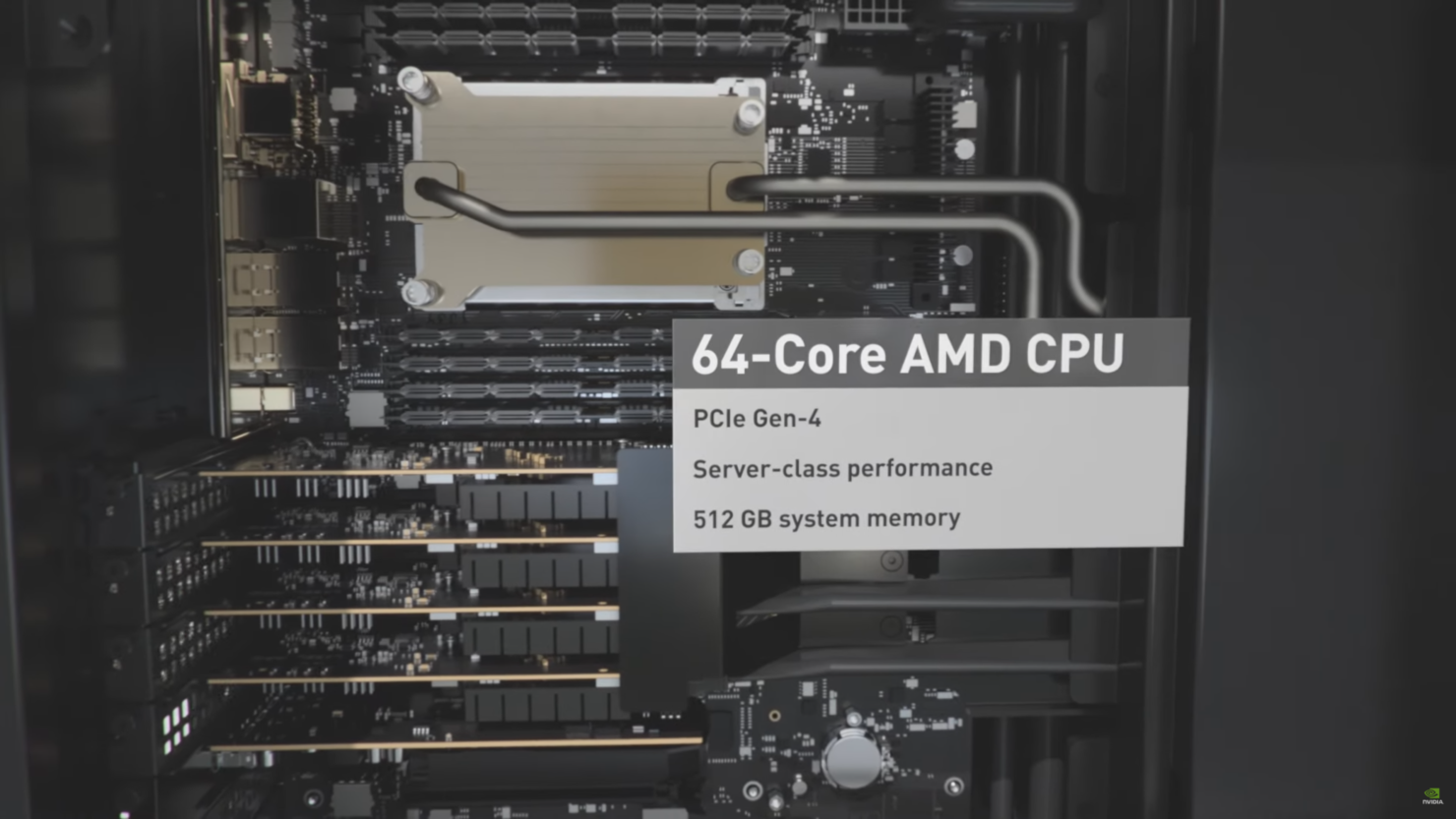

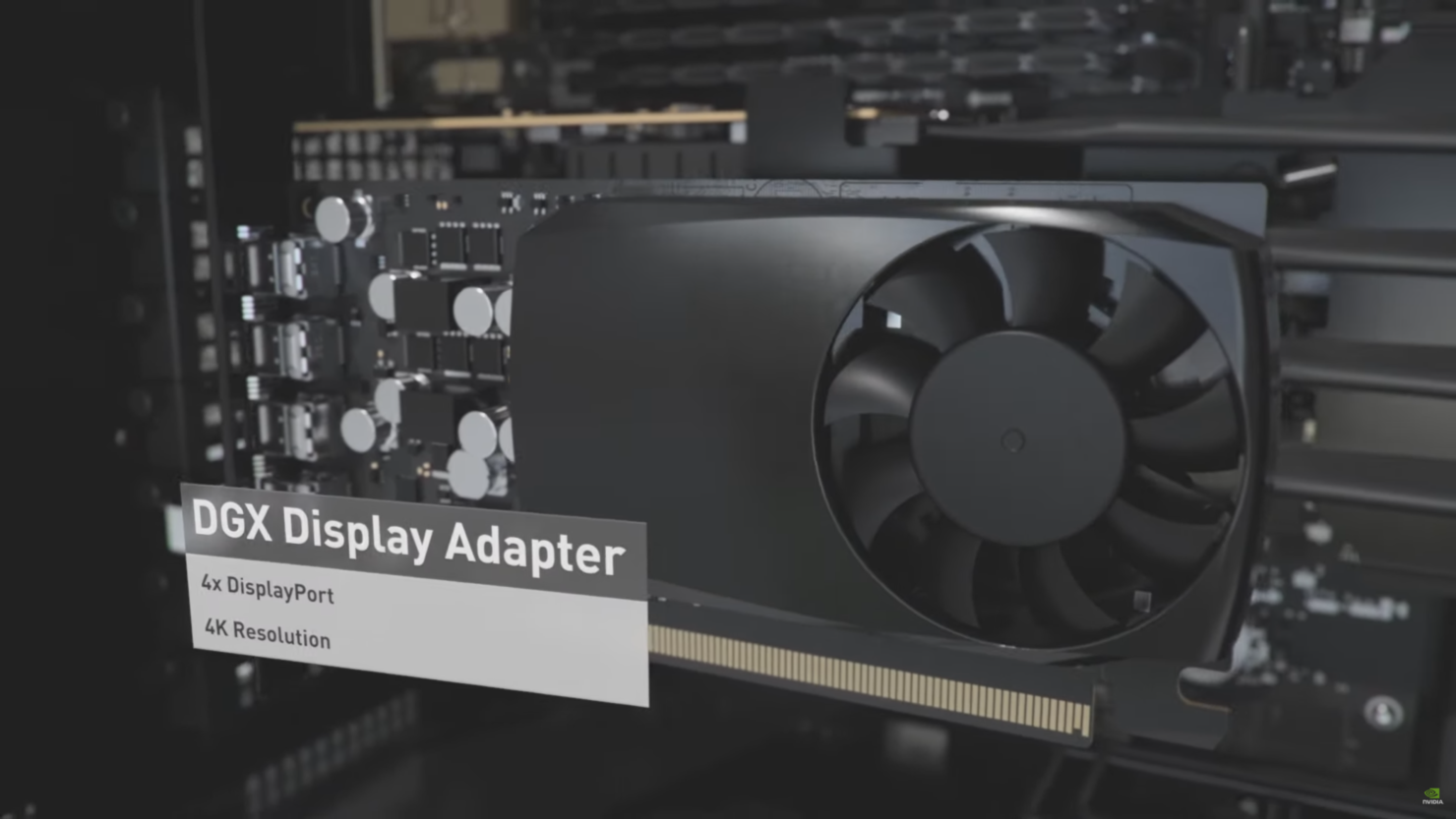

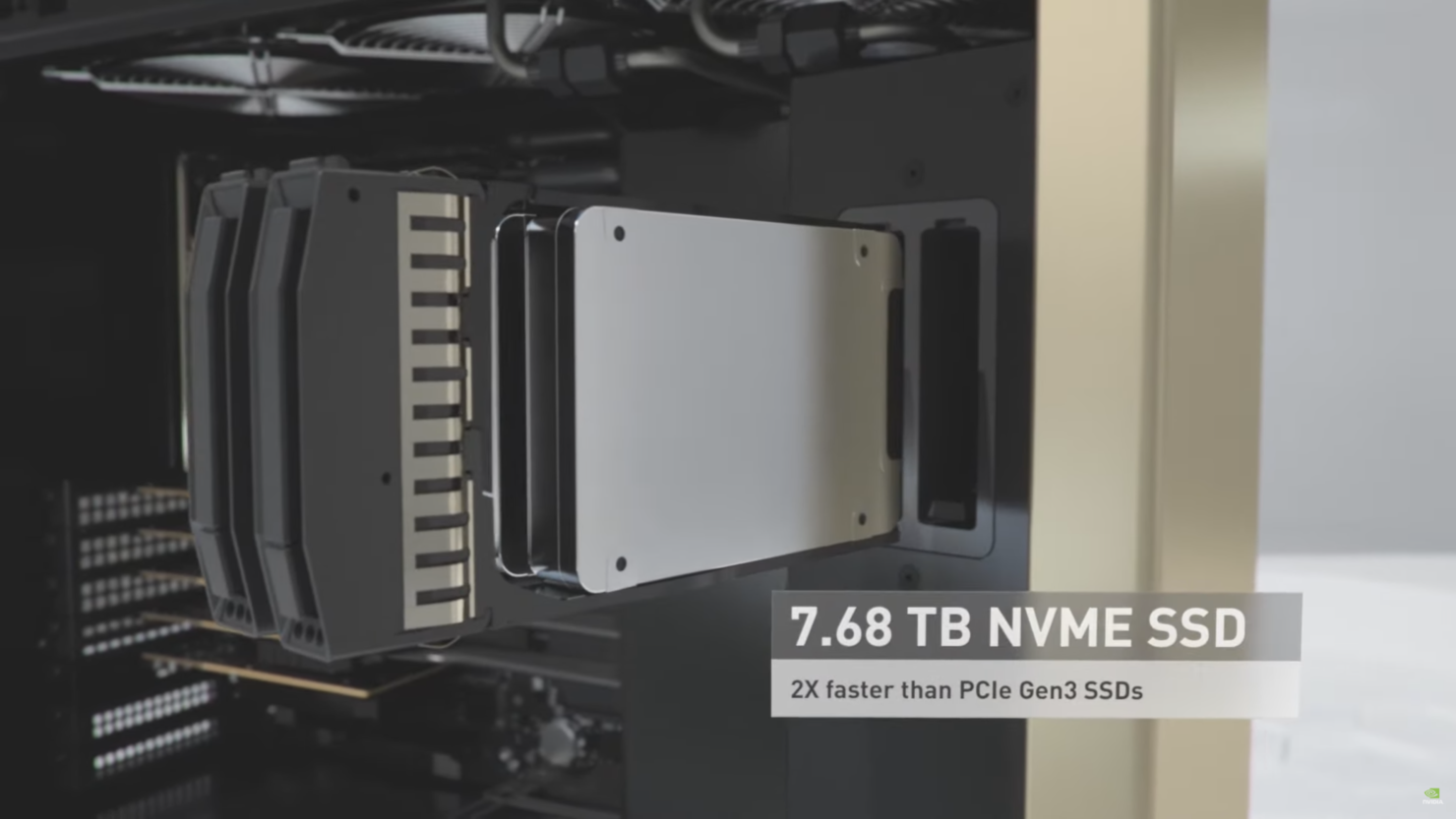

該系統本身包含一個AMD EPYC Rome 64核處理器,擁有完全的PCIe Gen 4支援,高達512GB的專用系統記憶體,用於系統的1.92TB NVME M.2 SSD儲存和最多7.68TB的NVME U.2 SSD儲存。為了實現連接,系統帶有2個10 GbE LAN控制器和一個用於遠程管理的1GbE LAN。顯示輸出通過獨立的DGX顯示卡提供,該卡提供4個DisplayPort輸出,最高支援4K分辨率。AIC擁有自己的主動散熱解決方案。

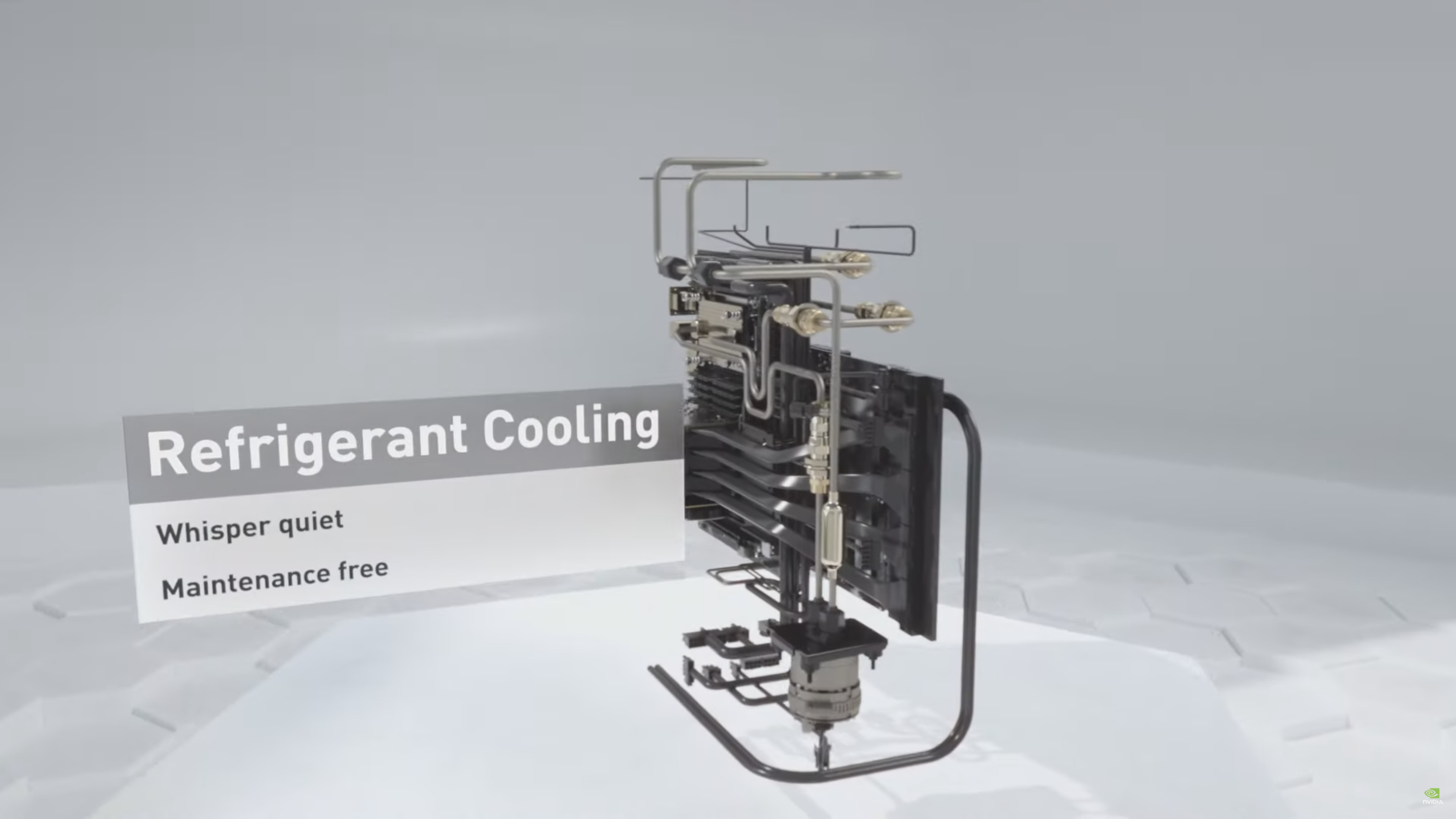

談到散熱解決方案,DGX Station A100將A100 GPU放在在機殼的背面。所有四個GPU和CPU均配有制冷散熱系統,該系統低噪音且無需維護。散熱器的壓縮機位於DGX機殼內。

在性能方面DGX Station A100提供2.5 Petaflops的AI培訓能力和5 PetaOPS的INT8推理能力。DGX Station A100也是同類中唯一支援MIG(多實例GPU)協議的工作站,它允許用戶分割單個GPU,從而可以更快,更高效地執行同時工作負載。

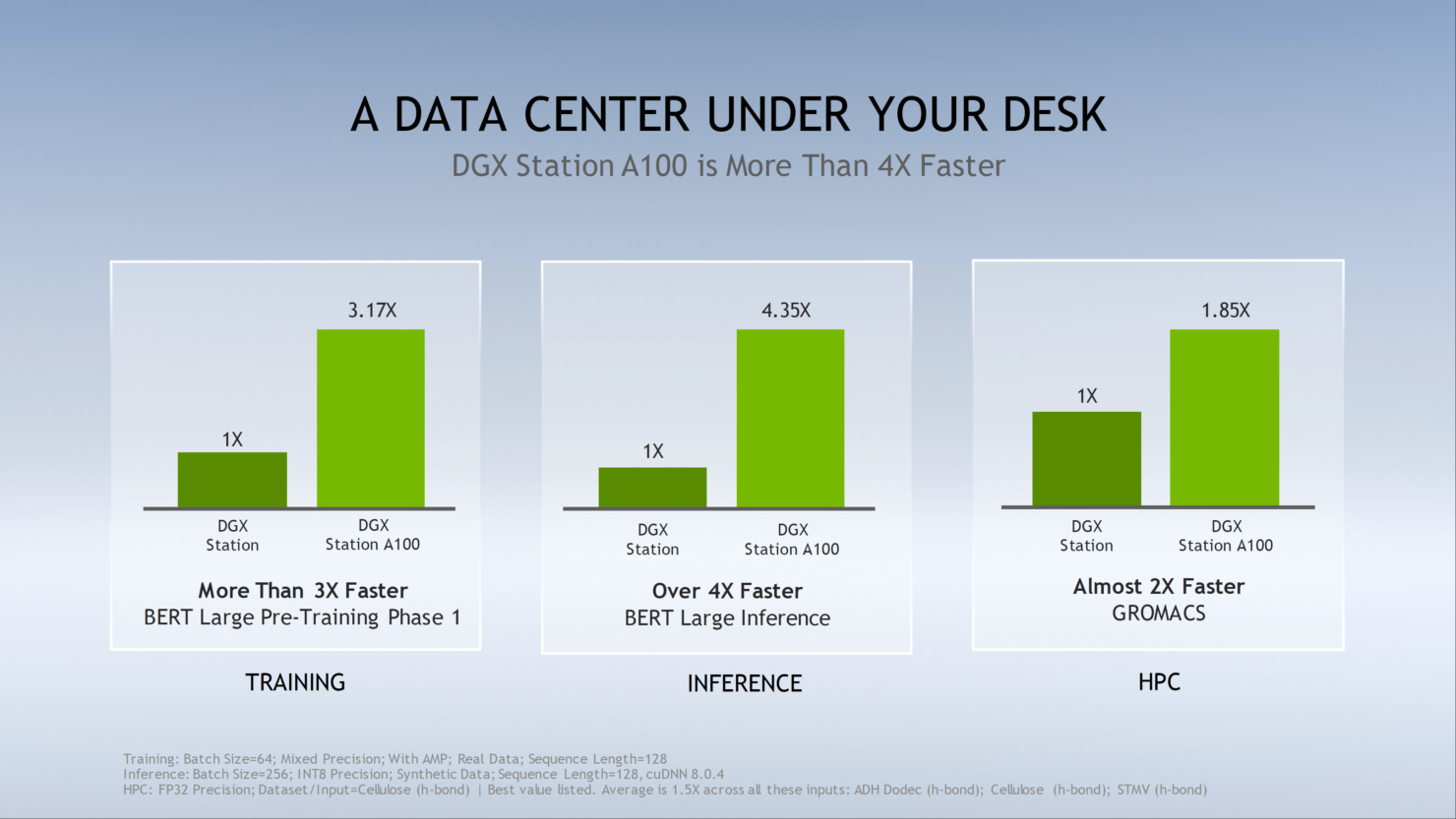

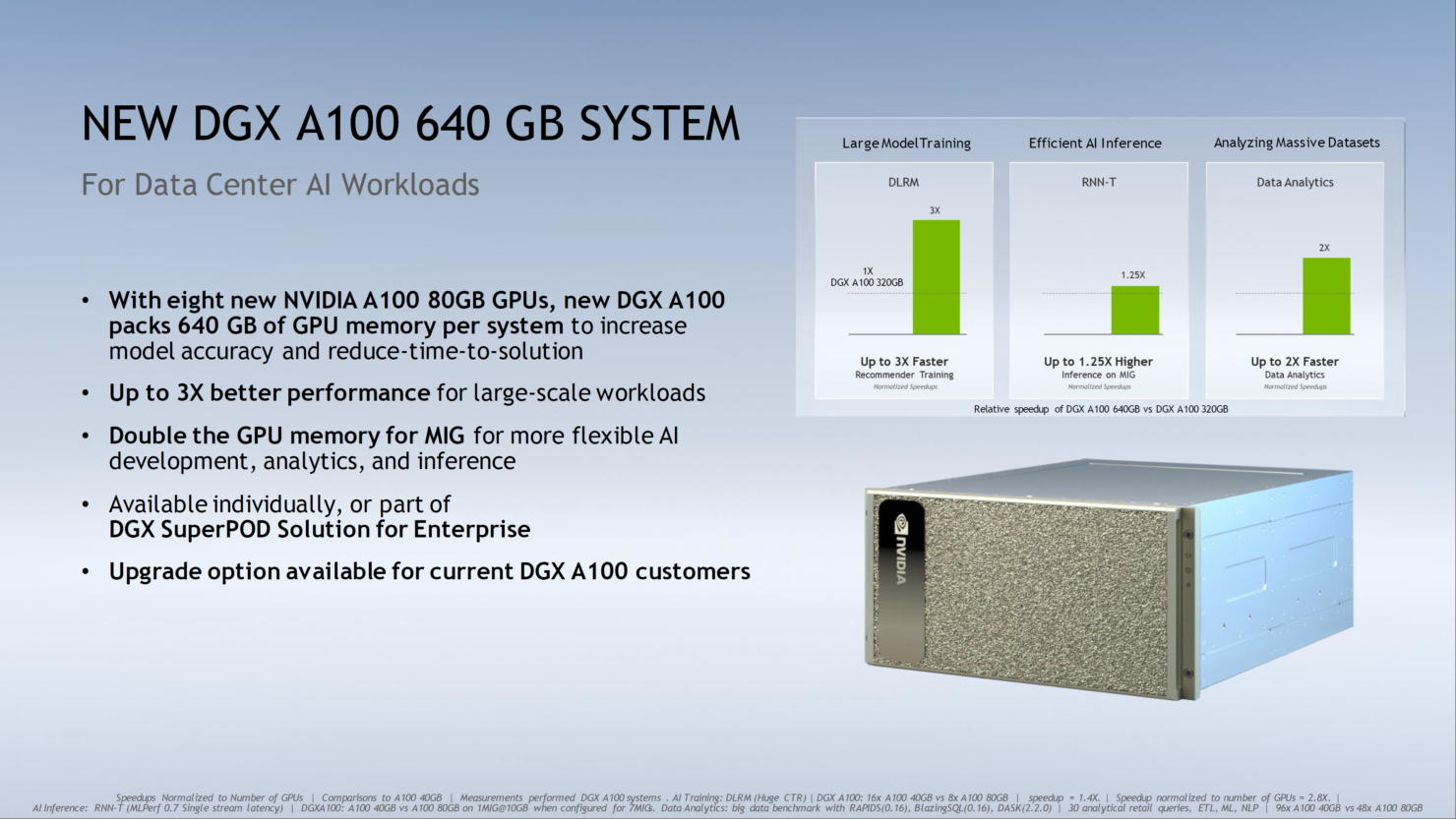

與原始DGX Station相比,新版本在訓練性能上提高了3.17倍,在推理性能上提高了4.35倍,在針對HPC的工作負載上提高了1.85倍。NVIDIA還更新了其DGX A100系統,使其也擁有80 GB A100 Tensor Core GPU。這些使NVIDIA的培訓性能比標準320GB DGX A100系統快了3倍,推理性能提高了25%,數據分析性能提高了2倍。

NVIDIA宣布DGX Station A100和NVIDIA DGX A100 640 GB系統將在本季透過NVIDIA全球合作夥伴網絡經銷商發售。該公司還將為DGX A100 320GB系統所有者提供升級選項,以升級到擁有八個80 GB A100 Tensor Core GPU的640GB DGX版本。NVIDIA尚未提供有關系統價格的任何訊息。