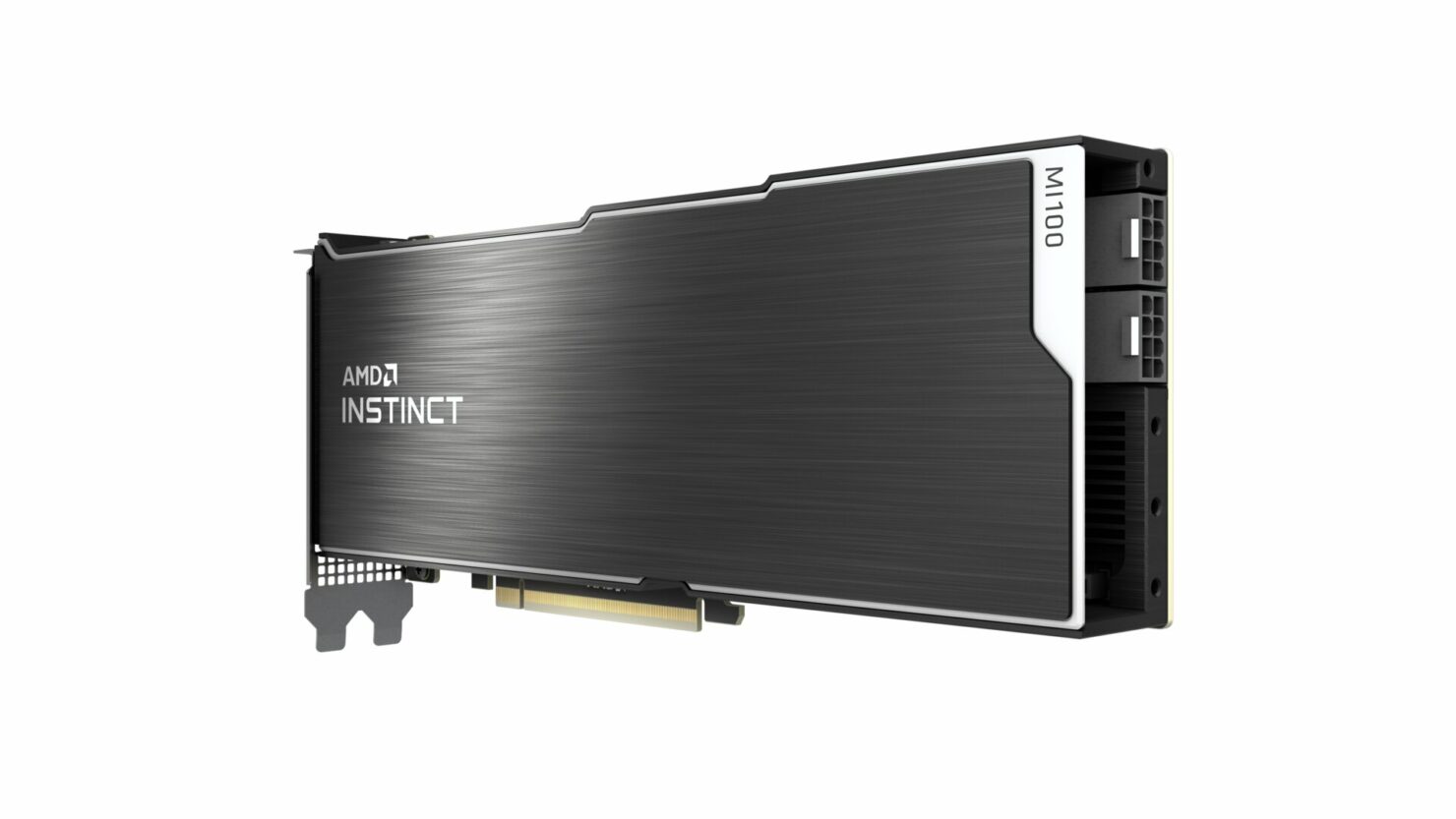

AMD官方推出Instinct MI100 32 GB HPC加速器,是採用CDNA架構的世界上最快的HPC GPU

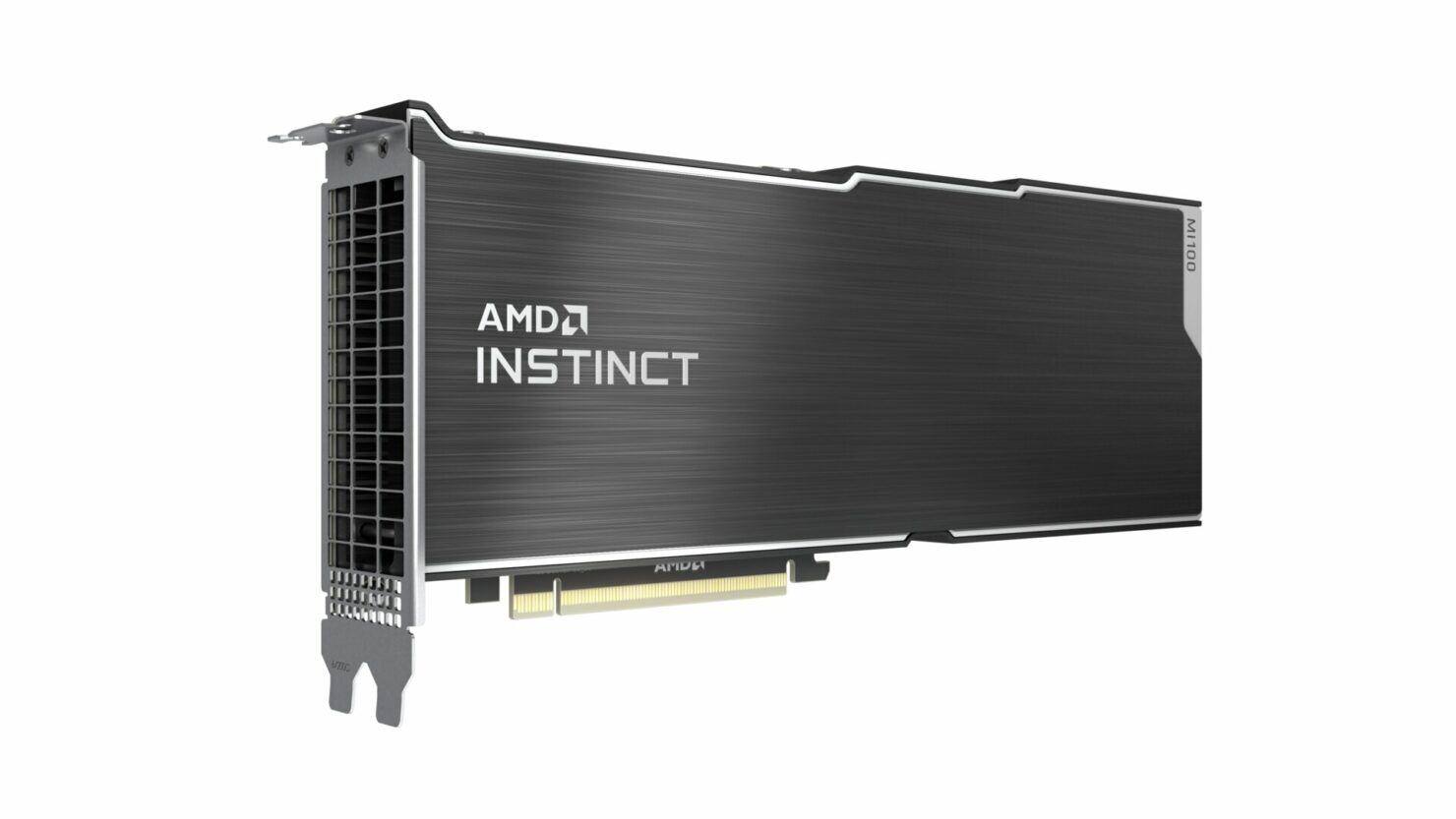

AMD正式宣布了其採用CDNA GPU的下一代Instinct MI100加速器,該加速器堪稱世界上最快的HPC GPU。Instinct MI100旨在提供世界上最快的雙精度計算功能,並為AI深度學習工作負載提供瘋狂的GPU性能。

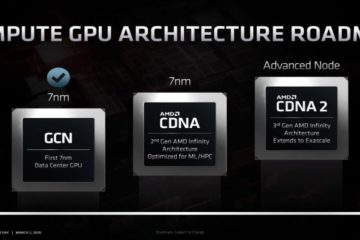

AMD的Instinct MI100將使用CDNA架構,該架構與本月晚些時候玩家可以使用的RDNA架構完全不同。CDNA架構是專門為HPC市場設計的,將與NVIDIA的Ampere A100和類似的加速卡相對應。

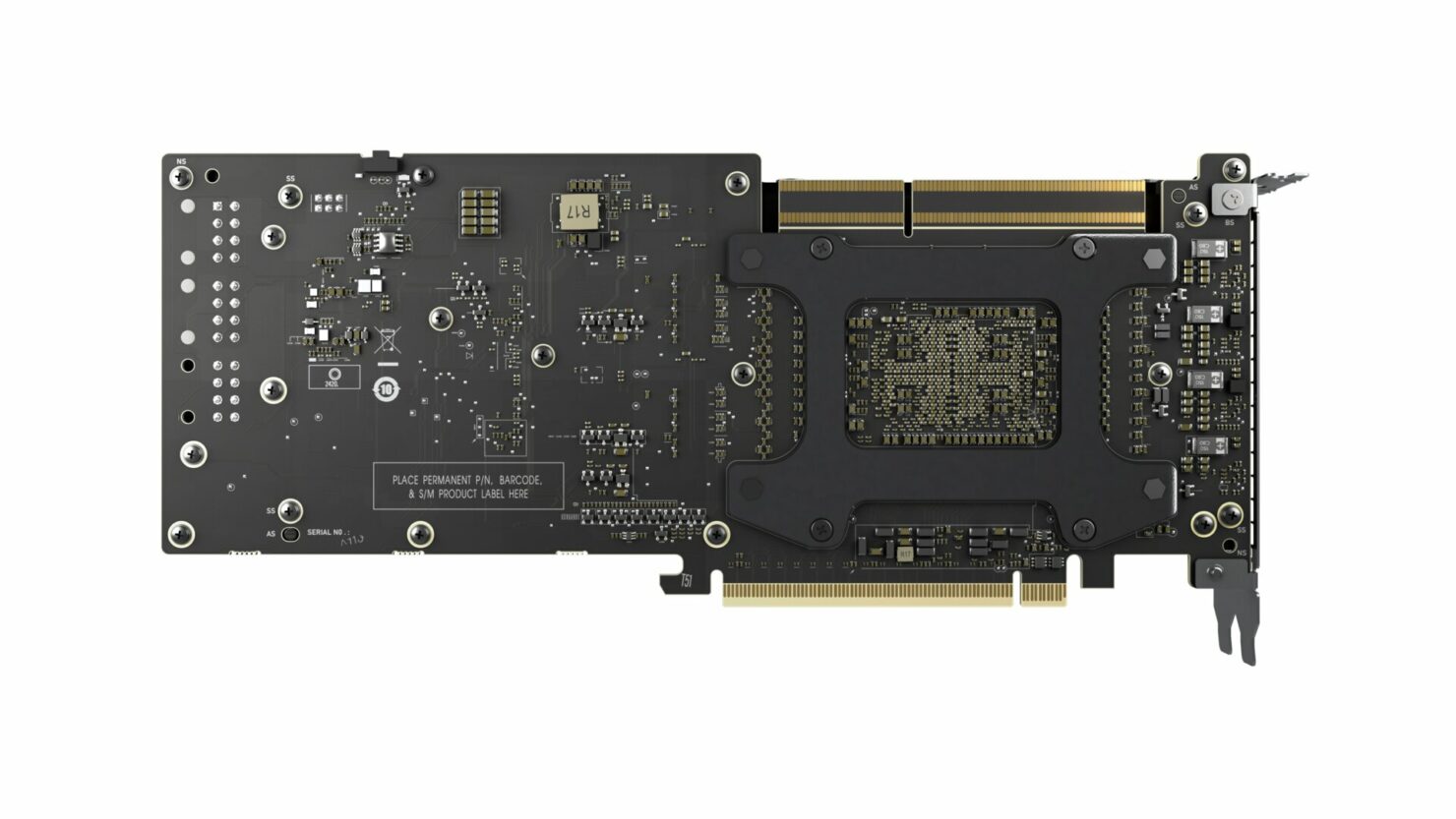

AMD Instinct MI100採用7nm CDNA GPU,總共可容納120個計算單元或7680個處理器。GPU的時脈速度配置為1500MHz左右,在FP64中提供11.5 TFLOP的峰值性能吞吐量,在FP32中提供23.1 TFLOP的峰值性能吞吐量,在FP16計算工作負載中提供185的TFLOP峰值性能。該加速器的總功耗為300W。

看到記憶體方面,AMD將為其Radeon Instinct MI100 HPC加速器配備總計32GB的HBM2。該顯示卡將支援4和8GPU配置,並通過新的Infinity Fabric X16互連進行通訊,該互連的額定頻寬為276GB/s。AMD使用的HBM2可提供1.23GB/s的有效頻寬,而NVIDIA的A100採用的HBM2e則提供了1.536GB/s的有效頻寬。

在性能方面將AMD Instinct MI100與NVIDIA Volta V100和NVIDIA Ampere A100 GPU加速器進行了比較。比較這些數字Instinct MI100的FP64提升了19.5%,FP32的性能提升了18.5%。但在FP16性能上NVIDIA A100比Instinct MI100擁有69%的優勢。

就實際工作負載性能而言AMD Instinct MI100在FP64和FP32工作負載中的性能/金額比率為2.1倍。這些數字與NVIDIA A100的性能進行比較。它們的性能比採用Volta的V100 GPU加速器快3倍/1.4倍/2.6倍。與MI60相比Instinct MI100在PIConGPU工作負載方面提高了40%。

據AMD稱其Instinct MI100 GPU加速器將在OEM和ODM使用,並將在2020年底與首批系統整合。